Introduction à l'économie

...et aux idées pour la comprendre

Ce site est le support à l'enseignement dispensé en L1 Économie à l'Université Paris Cité par Christophe DARMANGEAT. Il ne remplace en aucune manière le cours lui-même, ni la lecture attentive de certains ouvrages, dont ceux conseillés en bibliographie. Selon la formule consacrée, les propos qui y figurent n'engagent que la responsabilité de leur auteur.

Quelques éléments de logique

Les lignes qui suivent ne portent pas spécialement sur

l'économie. Leur propos est de donner quelques éléments de réflexion sur ce qu'est un raisonnement

(scientifique), et quelques manières dont on peut le justifier ou le

réfuter.

Ces différents éléments ne sont pas propres à

l'économie, mais l'économie y a fréquemment recours. Aussi font-ils

partie du bagage indispensable pour comprendre comment certains penseurs

ont pu construire leurs raisonnements, ou contester ceux des autres. Accessoirement, lorsque

vous devrez bâtir une dissertation, il vous sera très utile de maîtriser

ces notions pour défendre votre propre point de vue - si vous en avez un

- ou tout au moins, exposer convenablement l'articulation entre les

affirmations des différents auteurs.

1. Qu’est-ce qu'un raisonnement (scientifique) ?

Un raisonnement scientifique est une suite de propositions liées les

unes aux autres de manière logique (par des liens de cause à effet), et

qui mettent en jeu des phénomènes existant dans la réalité.

1.1 On ne peut raisonner que sur ce qui existe...

Si je dis que

sur la planète Zorglub, les habitants ont trois mains gauche à cause de

la composition particulière de leur ADN, j'ai formulé une proposition

logiquement articulée. Mais personne n'ayant jamais pu observer ni la

planète Zorglub, ni ses habitants, ni leur ADN, ce n'est pas

un raisonnement scientifique. Je n'ai fait qu'aligner des mots en

respectant formellement les règles de la logique, mais ces mots ne font

référence à aucune réalité. Au Moyen-âge, le maniement de raisonnements

logiques sans aucune référence au réel était connu sous le nom de

scolastique : on discutait gravement pour savoir quel était le sexe

des anges, ou combien de ces créatures pouvaient danser sur une pointe

d'aiguille. Mais évidemment, les observations d'anges étaient aussi

rares que celles de mes extraterrestres zorglubiens de tout à

l'heure... Vous pouvez aussi trouver un excellent exemple de cette

faute de logique classique dans le très beau film Ridicule, où le personnage joué par Bernard Giraudeau

prouve magistralement devant le roi l'existence de Dieu... juste avant

de commettre la gaffe de sa vie.

Au passage, dans certains cas, on peut avoir un doute sur le fait qu'un phénomène

existe ou non. Or, il est très important de comprendre qu'il n'est jamais possible de prouver que quelque chose

n'existe pas. Autrement dit, c'est toujours à celui qui affirme l'existence de quelque chose d'en apporter la preuve.

C'est bien ainsi que nous raisonnons dans la vie de tous les jours, si nous ne voulons pas devenir fous. Imaginons que quelqu'un vient

expliquer, par exemple, que nous sommes envahis par des extra-terrestres malfaisants qui tuent les humains et prennent leur apparence,

et qu'en conséquence, il faut exterminer ses voisins. Non seulement nous ne le croirons pas, mais s'il est passé à l'acte, aucun tribunal

ne retiendra le bénéfice du doute en disant qu'après tout, il a peut-être raison, puisqu'on ne peut pas prouver qu'il a tort (les extra-terrestres,

c'est bien connu, sont fichtrement rusés et il est impossible de les démasquer).

Ce point a depuis longtemps été établi par ceux qui ont réfléchi aux sciences, c'est-à-dire à la manière

dont il faut réfléchir pour connaître le monde. On le résume souvent par la formule (employée au départ dans les tribuaux romains : « ce qui

est affirmé sans preuve peut être nié sans preuve ». L'une de ses illustrations les plus parlantes a été proposée par le philosophe Bertrand Russell, avec l'exemple de la théière cosmique. C'est donc quelque chose d'essentiel : avant de raisonner sur des faits, ou des phénomènes, la première chose à faire est de s'assurer que les faits, ou les phénomènes, sur lesquels on raisonne, sont avérés. Et cela élimine d'emblée la quasi-totalité des pseudo-sciences...

1.2 La notion de nécessité (et quelques mots sur le hasard)

Poursuivons. Un raisonnement scientifique tente donc de mettre en

évidence des relations entre des phénomènes réels, qui sont des

relations de nécessité. Il s'attache à prouver que telle série de causes mène

nécessairement à telle série d'effets, en explicitant par quels

mécanismes.

Prenons un exemple tout simple, tiré de la vie

quotidienne. Je peux dire : « quand j'allume la lumière, cela fait

pleuvoir ». La preuve, c'est très exactement ce qui m'est arrivé l'autre jour

: j'ai appuyé sur l'interrupteur et toc, les premières gouttes sont

tombées sur mon balcon.

Cette

affirmation n'est évidemment pas un raisonnement scientifique, pour au moins deux raisons

:

- si j'allume de nouveau la lumière un certain nombre de fois, il ne se mettra pas pour autant à pleuvoir.

- je ne peux établir aucun lien causal entre le fait d'allumer la lumière et le fait qu'il se mette à pleuvoir.

Première chose : dans cet exemple trivial, il est évident que j'ai

établi une relation non nécessaire (car la coïncidence entre

les deux événements était simplement due au hasard). On parle alors de

hasard, ou de

contingence (on dira aussi que ce sont des événements contingents). Or

par définition, les énoncés scientifiques ne portent pas sur les relations

contingentes, mais comme je le disais, sur les relations nécessaires.

Parenthèse un peu compliquée : Attention néanmoins, la contingence et la nécessité forment un vieux

couple, qui a occupé la sagacité des philosophes durant des siècles. Car

bien qu'ils soient le contraire l'un de l'autre, ils sont souvent tous

deux présents à la fois dans le même phénomène. Vous trouvez cela

paradoxal ? Pensez à la roulette du casino. La suite de numéros qui va

sortir chaque soir est le fait du hasard. Elle est parfaitement

contingente (sauf si la roulette est truquée, mais nous admettrons que

ce n'est pas le cas). Pourtant, à travers cette

série de hasards, on sait que presque tous les soirs, il y aura un

gagnant à la roulette, et toujours le même : le patron du casino. Car les gains ont été

calculés en fonction des différentes probabilités de sortie des numéros.

Au final, la série d'événements contingents (les différents numéros qui

vont sortir chaque soir) produira un événement tout à fait nécessaire (l'enrichissement

du propriétaire). Cette présence simultanée dans les phénomènes d'une dimension contingente

et d'une dimension nécessaire est beaucoup plus fréquente qu'on ne le

croit généralement. Mais passons, car cette discussion nous

entraînerait trop loin. Fin donc de la parenthèse.

1.3 Causalité et corrélation

Venons-en maintenant à un deuxième aspect. Dans mon

exemple de la lumière et de la pluie, les deux points qui me

permettent de dire qu'il ne s'agit pas d'un raisonnement scientifique ne sont pas sans rapport : c'est bien à cause du point 2 qu'il y

a le point 1. C'est parce qu'il n'existe aucun lien causal entre le fait

d'allumer la lumière et le déclenchement de la pluie que je peux allumer

la lumière cinquante fois de suite sans qu'il ne se passe plus rien.

Mais les choses ne sont pas toujours aussi simples. Si je cesse de

parler de la lumière, et que je fixe mon attention sur un autre

phénomène, en disant : l'ouverture des parapluies par la population

entraîne l'apparition de la pluie, j'ai là aussi formulé un énoncé qui

est scientifiquement faux. Pourtant, cette fois-ci, ce que j'avais

appelé le point 1 est respecté : à chaque fois que les gens ouvrent

leurs parapluies, je peux constater qu'effectivement, il pleut. Je peux

donc renouveler l'expérience aussi souvent que je le veux, et constater

que les deux événements sont liés.

Le problème vient ici du point 2, et de lui seul :

dans mon (faux) raisonnement, j'ai tout simplement inversé la relation

de causalité.

Ce n'est pas parce que les gens ouvrent leurs parapluies qu'il se met à

pleuvoir, mais parce qu'il se met à pleuvoir que les gens se protègent

en ouvrant leurs parapluies.

Je viens de citer un exemple où deux

événements sont liés par une relation de causalité, et où l'erreur de

raisonnement consiste à inverser l'ordre de cette causalité (en nous

interdisant, du coup, d'expliquer comment elle fonctionne). Mais la

coïncidence régulière de deux événements peut aussi faire croire à

l'existence d'une causalité là où il n'y en a pas. Les soirs d'orage,

on constate à la fois de grands bruits (qu'on appelle des coups de

tonnerre) et des coupures électriques. Mais il serait bien téméraire

d'en déduire un lien de causalité entre les deux phénomènes ! Le bruit

n'entraîne pas des coupures électriques, pas plus que les coupures

électriques ne font du bruit. En l'occurrence, les deux phénomènes,

n'ont pas de lien de causalité entre eux, mais sont tous deux les

effets d'un troisième (la charge électrique contenue dans

l'atmosphère).

Voilà pourquoi, en conclusion, une théorie scientifique, quelle

qu'elle soit, ne peut se contenter de recenser les coïncidences - un

vocabulaire plus adapté parlerait de corrélations. Une corrélation

n'est pas une causalité (même si inversement, une causalité entraîne

forcément une corrélation). Pour être une théorie scientifique, un

raisonnement ne peut se limiter aux corrélations : il doit donc faire

apparaître les causalités et les expliquer.

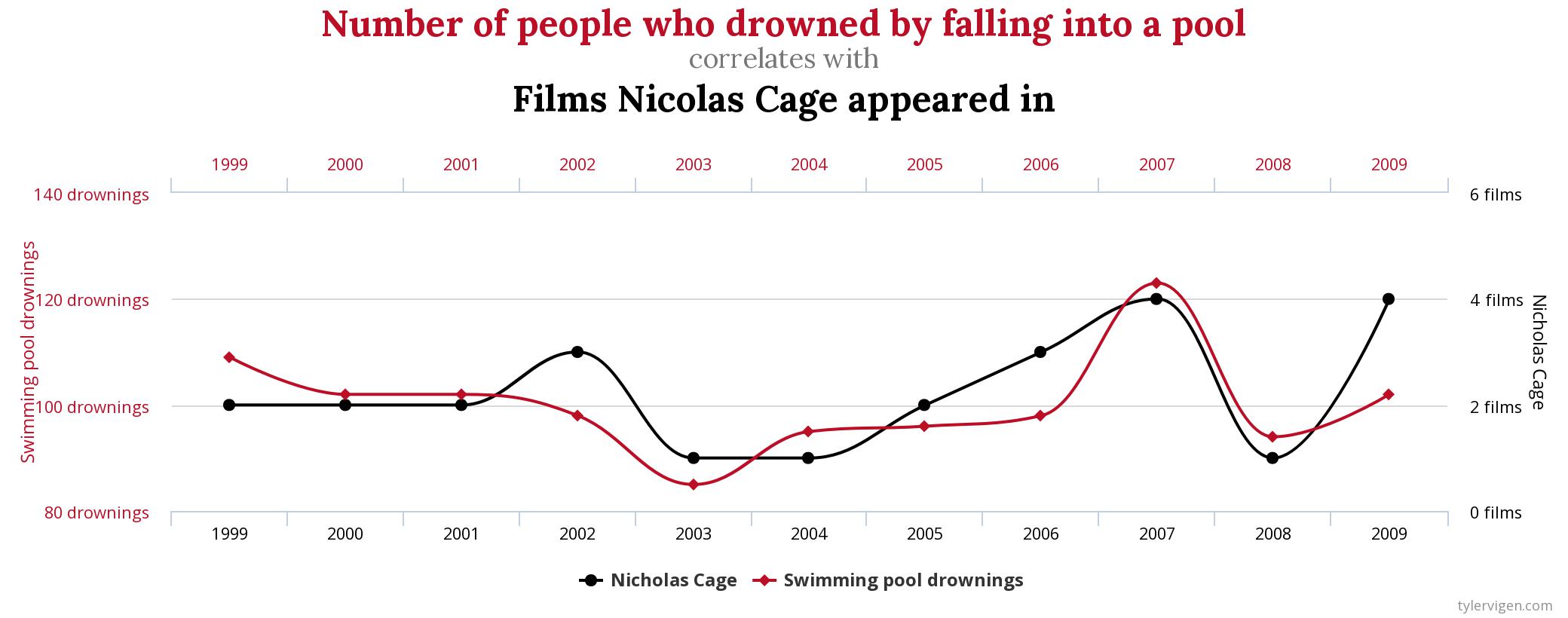

Il existe sur internet diverses ressources qui traitent ce problèe de manière humoristique. Le site Spurious correlations (corrélations fallacieuses), même s'il est en anglais, devrait

normalement vous arrracher quelques sourires. Par exemple avec ce graphique montrant la corrélation entre le nombre de morts par noyade dans les piscines aux États-Unis

et celui des films dans lesquels joue Nicholas Cage :

1.4 Parenthèse : condition nécessaire, condition suffisante

Quel que soit le domaine dans lequel on raisonne, il faut impéraivement maîtriser les notions logiques que sont les conditions nécessaires,

suffisantes, et leur traduction mathématique : implication, équivalence, contraposée. Tout cela peut impressionner, mais en fait, ce n'est pas si compliqué, et pour s'y retrouver on pourra raisonner à partir d'un exemple simple.

On dit que A implique B si, chaque fois que se produit A, alors, impérativement, B se produit aussi. En mathématiques, on notera : A ⇒ B.

Le point important est ici qu'il y a un sens : chaque fois qu'on a A, on a aussi B – cela ne signifie pas qu'à chaque fois qu'on a B, on a aussi A. Par exemple, on peut dire sans trop se tromper qu'à chaque fois qu'on se casse la jambe, on a mal. On peut donc dire « fracture du fémur » implique « douleur à la jambe ». On voit tout de suite que cela ne marche pas dans l'autre sens : toute douleur à la jambe n'est pas due à une fracture du fémur ! En d'autres termes, la fracture du fémur est une condition suffisante pour avoir mal à la jambe, mais elle n'en est pas une condition nécessaire.

De manière très intéressante, toute implication peut être « retournée » de la manière suivante : A ⇒ B peut aussi s'écrire non B ⇒ non A. Reprenons le cas de la fracture : je peux tout aussi bien dire que si on n'a pas mal à la jambe, alors on n'a forcément pas de fracture. Dès lors, on voit que la douleur à la jambe est une condition nécessaire pour qu'il y ait fracture. Les deux formulations A ⇒ B et non B ⇒ non A sont strictement équivalentes, et s'appellent des contraposées.

Reste le cas où l'implication fonctionne dans les deux sens, et où on a à la fois A ⇒ B et B ⇒ A. On dit alors qu'il y a équivalence entre A et B, ce qu'on note mathématiquement par A ⇔ B. On peut aussi dire que dans ce cas, A est une condition nécessaire et suffisante de B (tout comme B est une condition nécessaire et suffisante de A).

Je ne peux que le répéter : ces notions sont essentielles, quel que soit le domaine sur lequel on raisonne. Confondre une implication et une équivalence, prendre une condition suffisante pour une condition nécessaire (ou l'inverse), sont des erreurs de raisonnement très fréquentes... et redoutables.

1.5 Qu'est-ce qu'une fausse science ?

Pour en revenir aux critères qui définissent la science, il est utile de regarder ce qu'est une fausse science. Comment les fausses sciences

procèdent-elles, et pourquoi peut-on précisément dire qu'elles sont fausses

?

La liste des fausses sciences (exploitant toutes, sans exception,

la crédulité de nos contemporains à des fins lucratives) est hélas

bien longue. Je ne retiendrai que deux exemples, particulièrement

populaires dans notre beau pays : l'astrologie et l'homéopathie.

L'une comme l'autre sont de parfaits exemples de fausses sciences,

dans la mesure où elles ne répondent à aucune des deux conditions

dont j'ai parlé plus haut :

- les faits qu'elles prétendent expliquer ne sont pas des faits, dans la mesure où ils ne sont pas reproductibles. Personne n'a jamais pu établir par une étude sur pièces que le caractère des gens avait un rapport avec leur date de naissance, ni que les médicaments homéopathiques soignaient davantage que des morceaux de sucre. Bien sûr, on peut toujours citer des cas isolés à l'appui de ces affirmations (deux gémeaux qui ont le même caractère, ou quelqu'un qui s'est senti mieux après un traitement homéopathique). Mais ces cas isolés n'ont pas plus de valeur que mon interrupteur électrique qui déclenchait la pluie : pour qu'ils soient autre chose que des hasards, il faudrait pouvoir prouver qu'il y a une corrélation systématique entre les planètes et le caractère, ou entre les pilules homéopathiques et la guérison. Or, cette preuve n'a jamais été apportée ni par les astrologues, ni par les homéopathes (ni par personne d'autre, évidemment).

- les fausses sciences ne fournissent aucune explication sur le mécanisme des causalités qu'elles prétendent avoir découvertes : elles se bornent à affirmer que ces causalités existent, sans dire de quoi elles sont faites. Ainsi, aucun astrologue ne se hasarde à expliquer pourquoi la position des planètes est censée influencer le caractère ou la destinée des gens ; quant aux homéopathes, eux, ils avancent bien une explication, mais celle-ci ne s'appuie sur aucun mécanisme biologique ou chimique connu. Autrement dit, cette explication n'en est pas une : elle est, si l'on veut, un jeu de mots, une association d'idées. Mais elle ne représente pas une chaîne de causalités valide.

Les fausses sciences nous aident donc a contrario à comprendre ce qu'est la

science (la vraie). Là où les fausses sciences traitent de

relations imaginaires, la science authentique traite de

corrélations dont la réalité peut donc être prouvée. Et là où les fausses sciences renoncent (et pour cause

!) à mettre en évidence des relations de causalité, la tâche

principale de la science authentique consiste précisément à

découvrir ces relations.

2. L'abstraction

Une caractéristique partagée par tous les raisonnements

scientifiques est d'être (plus ou moins) abstraits. Tout le monde sait

cela, mais tout le monde ne se demande pas toujours suffisamment

pourquoi il en est ainsi, et ce que veut dire en l'occurrence le mot « abstrait

».

Pour bien des gens, quelque chose d'abstrait, c'est

quelque chose de compliqué. La preuve, les raisonnements abstraits, que

ce soit en mathématiques, en philosophie ou en économie, sont les plus

difficiles à comprendre. Pourtant, en réalité, c'est très exactement le contraire.

Je vais tenter de vous montrer, dans les lignes qui suivent, que

par définition, abstraire c'est simplifier

; et qu'un concept abstrait, c'est

par définition un concept plus simple qu'un concept concret.

Vous ne me croyez pas ? Prenez le sens courant du mot

« abstraire ». Je peux dire par exemple que : « si on fait abstraction de son humour

affligeant, le prof d'éco est à peu près fréquentable ». Cela veut

dire qu'au moins par la pensée, on peut mettre un aspect de côté chez le prof d'éco, celui qui

concerne son humour — ou ce qu'il croit être de l'humour. Eh bien,

abstraire, c'est toujours mettre de côté certaines caractéristiques,

pour obtenir un objet plus simple, et sur lequel on pourra raisonner

plus facilement.

Considérons la discipline scientifique qui manipule par excellence

des objets abstraits : les mathématiques. En mathématiques, on travaille

avec des points, des droites ou des cercles, toutes choses

qui possèdent un certain nombre de propriétés. Mais les points, les

droites et les cercles des mathématiques sont infiniment plus simples

que les points, les droites et les cercles que l'on rencontre dans la

réalité ! Dans la réalité, aucune droite n'est parfaitement droite.

Toutes les droites (plus ou moins droites) ont une épaisseur (variable),

etc. Ce qui fait que les théorèmes, les règles qui s'appliquent à la

perfection aux droites simples et imaginaires des mathématiciens, ne

fonctionnent qu'à peu près, et parfois très mal, pour les différentes

droites de la réalité. Et il en va de même pour tous les objets que

manipulent les mathématiques : ils sont simples — en tout cas, ils

sont simplifiés — et c'est ce qui permet d'établir des lois générales,

des théorèmes et des raisonnements qui fonctionneront dans toutes les

situations.

En économie, comme en mathématiques, si l'on veut produire un

discours scientifique, si l'on veut établir des règles, des causalités,

entre les phénomènes, on est obligé de partir d'hypothèses et de faits

simplifiés (on dit aussi stylisés»). C'est-à-dire qu'on est obligé

de partir de simplifications, d'abstractions. Toute théorie

économique commence par une série d'hypothèses simplificatrices : elle

considèrera par exemple que les agents économiques sont rationnels, que

la concurrence est pure et parfaite, que les capitaux sont parfaitement

mobiles, etc.

J'en viens maintenant à une remarque très importante. On croit trop souvent pouvoir réfuter une théorie en lui faisant

reproche du caractère abstrait ou simplificateur de ses hypothèses.

Pourtant, en lui-même, cet argument n'est jamais recevable, car

le fait

de partir d'hypothèses simplificatrices est la condition nécessaire de

toute théorie scientifique. Dire qu'une théorie est fausse parce qu'elle

s'appuie sur des hypothèses abstraites, c'est condamner par principe

toute théorie, c'est-à-dire toute connaissance scientifique.

On revanche, on peut tenter de réfuter un raisonnement en montrant

que les hypothèses sont trop simplificatrices par rapport au problème

traité — ce qui n'est plus du tout la même chose. On va alors chercher à

montrer que si on introduit une complexité supplémentaire dans une

hypothèse afin de la rapprocher de la réalité, la conclusion du

raisonnement en est changée. Ce type d'objection est parfaitement

pertinent : il signifie que des hypothèses ne sont jamais par

elles-mêmes trop abstraites, ou pas assez abstraites. Elles ne peuvent

être trop ou pas assez abstraites que par rapport au problème traité.

Un exemple simple ? Si je dis que « l'homme est un être qui

naît et meurt », ce que je désigne par « l'homme » est très général (très

abstrait), puisque je parle des êtres humains quels que soient leur sexe,

leur époque, leur lieu de naissance, leur régime alimentaire, leur

couleur de cheveux, etc. Pourtant, du point de vue de

ce que j'affirme, cette abstraction est légitime, puisque tout être

humain est effectivement né et devra effectivement mourir.

Si en revanche je dis que « l'homme se caractérise par

son sens de la propriété », je m'expose à l'objection selon laquelle dans un passé

pas si lointain, les êtres humains ignoraient à peu près tout de ce que nous

appelons la propriété, et que celle-ci a été une invention, un produit

de l'évolution historique. Il faudrait donc en conclure que les

chasseurs-cueilleurs nomades, par exemple, ne sont pas vraiment des hommes... ou que

« l'homme » de mon hypothèse de départ était un concept trop abstrait pour vérifier l'énoncé qui suivait.

Pour que l'énoncé redevienne juste, il faudrait préciser qu'il ne s'agit pas de l'homme en général, mais de certains hommes ,

en précisant en particulier dans quelles sociétés ils vivaient.

Conclusion, « l'homme » (fut-il économique : homo

œconomicus, comme aiment à le désigner en latin certains économistes) n'est pas en lui-même un concept adéquat, ou

trop abstrait : il ne l'est que vis-à-vis du problème à traiter. En

économie, il en va de même avec tous les concepts abstraits que l'on

peut être amené à employer, qu'il s'agisse du marché, du prix, du

consommateur, etc. Ils ne sont jamais adéquats, ou trop abstraits, par

eux-mêmes : ils ne le sont que vis-à-vis de certaines caractéristiques

que l'on veut mettre en évidence.

3. Le formalisme

En économie, comme en sciences en général, on emploie souvent les

termes de « formel », ou de « formalisme ». Qu'entend-on par là ?

Est formel ce qui a trait à la forme d'un concept, indépendamment de

son contenu. Un

formalisme, c'est une mise en forme, une organisation des propriétés

formelles des objets que l'on manipule. Tout cela reste un peu obscur ?

Je m'explique.

Le formalisme est une des conséquences de l'abstraction. La science

formelle par excellence, ce sont les mathématiques : elles se

préoccupent exclusivement de quantités, de variations, de rapports de

grandeur, sans jamais qu'on ait à se demander ce que ces quantités

représentent dans la réalité. Les règles de l'addition restent les

mêmes, qu'on soit en train d'ajouter des pommes de terre ou des bombes thermonucléaires.

Pour les mathématiciens, cela n'a aucune espèce d'importance. Ils se

fichent comme de leur première équation de ce que les nombres qu'ils

manipulent représentent, car seules les intéressent les propriétés de

ces nombres.

En économie, tout comme en physique, les choses sont assez

différentes. La connaissance scientifique va nécessairement présenter un

aspect formel (autrement dit, en gros, un aspect mathématique). Si je me

donne quelques concepts de départ (le consommateur, le marché, etc.) et

que je leur attribue des propriétés quantifiables (c'est-à-dire que je

formalise mes hypothèses) je vais pouvoir étudier de manière rigoureuse

l'ensemble du système que produit leur interaction, et peut-être en

découvrir des caractéristiques insoupçonnées. Le formalisme n'est jamais

très loin de la modélisation, où l'on tente de produire un ensemble de

relations quantitatives (mathématisées) de la réalité, qui la décrivent

de manière pertinente.

Le problème, c'est qu'en économie on sait qu'en procédant ainsi, on

simplifie une réalité très complexe. Le consommateur — si tant

est que cette abstraction ait un sens — se laisse difficilement réduire

à une série d'équations, aussi alambiquées soient-elles. De même, les relations économiques n'existent

que dans un environnement social produit de l'Histoire, des

institutions, des cadres juridiques, etc. Toutes ces choses font partie

intégrante de la réalité économique ; pourtant, elles se prêtent très

mal, pour ne pas dire pas du tout, à la formalisation. On ne peut les

comprendre que par une approche qualitative, et non quantitative.

Alors, formalisme or not formalisme ? Là encore, tout dépend de la

question étudiée. La réalité économique est vaste, et selon le problème

que l'on veut résoudre, le formalisme pourra se révéler un outil

extrêmement puissant ou, au contraire, un handicap. Le formalisme

n'est donc pas bon ou mauvais en soi. C'est un outil, qui peut être

indispensable ou nuisible selon la manière dont il est utilisé.

J'ajouterai pour finir que si aucun économiste n'a

jamais rejeté le recours au formalisme, certains courants de pensée

se sont cependant montrés beaucoup plus friands que d'autres de

cette manière de procéder. Nous verrons que c'est particulièrement

vrai des néoclassiques, qui revendiquent ce développement du

formalisme comme un gage de rigueur et de scientificité. Ce que

n'ont pas manqué de leur reprocher certains de leurs contradicteurs,

qui les ont accusé de déployer ce formalisme afin de mieux

dissimuler les hypothèses (inacceptables, selon eux) sur lesquelles

il repose. Plus d'un siècle après, le débat reste ouvert

et rebondit régulièrement...

4. Critique interne et critique externe

Si une théorie scientifique est une suite de

déductions logiques à partir de certaines hypothèses, il y a

globalement deux manières de la réfuter.

Soit on accepte les hypothèses,

mais on montre qu'elles ne conduisent pas aux conclusions proposées.

On met donc en évidence une faille à l'intérieur même de la

série de déductions logiques : il s'agit d'une critique dite interne.

Soit on récuse la validité des hypothèses pour traiter le problème, en

montrant que d'autres hypothèses, plus réalistes, conduisent à des

conclusions différentes. On rejette donc dans ce cas l'ensemble de la

chaîne causale, et l'on se place en quelque sorte à l'extérieur de

cette chaîne : on parle alors d'une critique externe.

Naturellement, quand on veut se faire plaisir et démolir un

adversaire de fond en comble, rien n'empêche de mener à la fois une

critique interne et une critique externe, sur le mode : « si mon

estimé collègue savait raisonner correctement, il se serait rendu

compte que ses propres hypothèses conduisent à de toutes autres

conclusions que ce qu'il affirme. Fort heureusement, son erreur est sans

conséquences, car les hypothèses en question sont de toutes façons

parfaitement inadmissibles ». C'est ce qui s'appelle avoir le beurre,

l'argent du beurre, et la peau de l'économiste.

Il est très important, pour comprendre les différents courants

économiques et la manière dont ils se sont constitués historiquement,

de situer sur quels points ils se sont adressés des critiques internes

ou externes, dans quelle mesure ils ont partagé certaines hypothèses

ou qu'ils les ont, au contraire, récusées.

5. « Toutes choses égales par ailleurs »

« Toutes choses égales par ailleurs » (en latin, si vous

voulez paraître distingués, « ceteris paribus ») est un mode de raisonnement

que l'on retrouve dans toutes les disciplines scientifiques

dès que l'on a affaire à

un phénomène mettant en jeu plusieurs variables. C'est-à-dire, dès

que plusieurs causes (plusieurs facteurs) peuvent influer sur une

même conséquence.

Un raisonnement fréquent dans la vie courante...

Prenons un exemple dans la vie courante. Si je dis que plus une

voiture roule vite, plus elle consomme d'essence, cela paraît être

une proposition de bon sens. Pourtant, dans bien des circonstances,

cet énoncé devient faux. Une formule 1 qui roule à 80 km/h consomme

davantage qu'une Clio à 120 km/h. La même Clio, si on lui met une

remorque, consommera plus à 80 km/h qu'elle ne le faisait à 120 km/h

sans remorque, etc.

En l'occurrence, la vitesse est un des facteurs

qui influent sur la consommation, mais ce n'est pas le seul. Donc,

pour pouvoir affirmer que plus on roule vite, plus on consomme, je

dois mettre de côté toutes les autres raisons pour lesquelles on

peut très bien rouler moins vite et consommer davantage. Autrement

dit, mon énoncé est vrai seulement si l'on met de côté les autres

changements qui peuvent avoir lieu, et qui peuvent contrecarrer la

causalité que je pense avoir découverte. La bonne formulation,

celle qui est la plus rigoureuse, est donc : « toutes

choses égales par ailleurs, l'augmentation de la vitesse d'une

voiture fait augmenter sa consommation d'essence ».

Voilà pourquoi, en physique, on essaye de raisonner systématiquement

par l'analyse, c'est-à-dire par la séparation des différentes causes. Lorsqu'on

dit que telle cause produit tel effet, on doit être certain que

toutes les autres causes possibles ont été écartées. C'est-à-dire

que dans mon exemple, si je constate une augmentation de la

consommation, celle-ci est bien due à l'augmentation de la vitesse,

et à elle seule.

Il faut donc que j'établisse qu'une seule variable (la vitesse) a

changé, et que toutes les autres variables (le modèle de la voiture, son

poids, la pression des pneus, la vitesse du vent, etc.) sont restés

identiques.

En physique, on dispose de laboratoires dans lesquels on peut assez

facilement créer et reproduire des expériences pour isoler chaque variable, et voir ce qui se passe lorsqu'on modifie uniquement

la pression, ou uniquement la température, etc.

En économie, en revanche, on est doublement pénalisé.

- D'une part, parce que que le système qu'on étudie — la société — est un système extrêmement complexe, qui possède a priori des millions de variables. Il est donc très difficile d'identifier quelle variable joue quel rôle... et surtout, d'être certain que le résultat qu'on croit avoir dégagé n'est pas dû au fait qu'une autre variable soit subrepticement venue perturber l'observation.

- D'autre part, second handicap, il n'existe aucun laboratoire permettant d'isoler ces variables. On est obligé de raisonner à partir d'une réalité où les millions de variables s'entremêlent, et où elles passent leur temps à se modifier. D'où le fait que c'est uniquement par la pensée, par le raisonnement, que les économistes vont tenter de procéder à cette analyse, et de repérer si « toutes choses » sont réellement « égales par ailleurs », et si par conséquent on peut tirer ou non une conclusion d'une série d'observations.

Cela ouvre évidemment la porte à toutes les arguties et à toutes

les échappatoires.

Prenons un exemple parfaitement imaginaire et stupide, mais

néanmoins tout à fait significatif. Ayant déterré un gros paquet de

statistiques, un économiste affirmera pouvoir prouver, chiffres à

l'appui, que l'augmentation du taux d'intérêt conduit à

l'augmentation du taux de chômage. Un autre aura toujours beau jeu

de lui répondre que dans cette affaire, on a oublié un élément

fondamental, à savoir le solde du commerce extérieur, qui a varié

durant cette période, et que le premier économiste n'a pas pris en

compte. Que c'est

celui-ci qui est en fait le vrai responsable de l'augmentation du

chômage. Et qu'en réalité, l'augmentation du taux d'intérêt, par

elle-même, fait baisser le chômage. Ce qu'on aurait facilement pu

constater... si toutes choses étaient restées égales par ailleurs.

Bien entendu, tout cela ne signifie pas qu'en économie, on

ne peut rien dire, ni rien démontrer. Mais cela éclaire les

difficultés qu'il y a à élaborer une réelle preuve dans cette

discipline, pour les raisons

déjà évoquées.

...et en mathématiques

Je ne saurais terminer sur ce point sans évoquer les outils mathématiques qui permettent de raisonner sur ces situations.

Je présente toutes mes excuses si ce qui suit ne fait qu'enfoncer quelques portes qui sont censées être grandes ouvertes, mais mon petit doigt (et mes

cheveux blancs) me disent que je ne ferai pas forcément le voyage pour rien.

En mathématiques, l'objet qui décrit les relations entre plusieurs quantités (plusieurs variables)

s'appelle une fonction. Parmi ces quantité, l'une est considérée comme le résultat, ou la valeur de la fonction,

les autres sont considérées comme les données de départ, et appelées les variables. Par exemple, la

consommation d'une voiture (le résultat) est fonction des variables que sont sa vitesse, son poids, le volume de son moteur, etc.

Pour le mathématicien,

la nature réelle des variables n'a aucune espèce d'importance : qu'il s'agisse de températures, de populations, d'indices boursier ou du tour de taille de

ma grand-mère, seul l'intéresse les relations quantitatives qui existent entre elles et le résulat de la fonction.

Par exemple, si une quantité varie proportionnellement à une autre (la vente de

glaces par rapport à la température, les mensonges d'un gouvernement par rapport à sa baisse dans les sondages) on dira qu'on est face à une fonction

affine, et celle-ci sera représentée par une droite.

En plus de la relation entre les quantités globales (« Combien est-ce que je consomme quand je vais à telle vitesse ? »)

il arrive très souvent qu'on s'intéresse aussi aux relations entre les changements des variables (« Combien est-ce que je consomme en plus quand j'accélère d'1 km/h à 90 km/h ? »).

Ainsi, on peut construire une nouvelle fonction, qui décrit les relations entre le changement de valeur d'une variable, et le changement de valeur

de la fonction de départ. Cette seconde fonction est dite fonction dérivée (ou, pour les intimes, dérivée tout court) de la fonction de départ.

Par exemple, si l'on étudie la distance parcourue par une voiture en fonction du temps écoulé depuis le départ d'une course, la fonction dérivée décrira les variations

de la distance parcourue en fonction du temps... autrement dit la vitesse. On peut d'ailleurs tout à fait pousser un cran plus loin et étudier la dérivée de la dérivée,

en l'occurrence les variations de la vitesse en fonction du temps, c'est-à-dire l'accélération.

Dans les problèmes mathématiques de l'enseignement secondaire, on n'étudie la plupart du temps que des fonctions à une seule

variable , ce qui donne la sempiternelle notation f(x), où x est la variable. Dans ce cas, lorsqu'on étudie les variations de la fonction, donc la dérivée, c'est forcément

par rapport aux modifications de cette variable unique. On parle donc de « la » dérivée, vu que par définition, il ne peut y en avoir qu'une seule.

Mais il existe des tas de problèmes, en physique... ou en économie, où on doit construire des

fonctions à plusieurs variables, comme dans l'exemple de la consommation d'essence que je prenais plus haut. Dans ce cas, lorsqu'on étudie les variations

de la fonction, on doit préciser par rapport aux variations de quelle variable. Autrement dit, lorsque j'étudie l'influence de plusieurs facteurs sur la

consommation de la voiture, je dois isoler l'action de la vitesse, celle du poids, celle de la puissance du moteur, etc. Je dois donc dériver ma fonction

par rapport à l'une de ces variables, et préciser évidemment laquelle. Une telle dérivée s'appelle une dérivée partielle.

Si vous avez compris ce qui précède, la conclusion s'impose d'elle-même : les dérivées partielles sont les outils mathématiques

qui permettent de mener un raisonnement toutes choses égales par ailleurs. Et même si ce type de raisonnement n'est pas forcément formalisé sous

la forme de fonctions mathématiques, le principe qui le guide est très exactement celui qui guide les dérivées partielles.

6. Partialité et objectivité

Je ne cesserai de le répéter durant ce cours : en économie,

rien (ni personne) n'est jamais innocent... même quand il prétend le contraire. L'économie est une

science qui touche directement aux intérêts sociaux, en

particulier à la richesse. Or, on sait à quel point le

portefeuille est un organe sensible... et directement relié au

cerveau.

Dès lors, tout discours de science économique est

nécessairement un discours partisan, dans la mesure où il légitime

certains faits, en condamne d'autres, érige des normes sur la

manière dont devrait être organisée la société, etc. (le terme de

« partisan » ne veut pas dire ici « lié à un parti politique », mais,

plus largement, représentant certains intérêts sociaux et, du

coup, se heurtant à d'autres). J'affirme qu'on ne peut rien

comprendre aux raisonnements économiques, à leur histoire, à leurs

rapports mutuels, si on ignore cette dimension fondamentale.

Encore une fois, certains courants revendiquent haut et fort ce

point de vue partisan (nous verrons que c'était par exemple le cas

de Ricardo ou de Marx), tandis que d'autres le récusent. Mais il n'est pas

difficile de montrer que dans tous les cas, qu'on l'ait voulu ou

non, qu'on le proclame ou qu'on veuille le dissimuler, les

affirmations économiques ne sont pas, ne peuvent jamais être

neutres.

Cela veut-il dire qu'en économie, on n'a finalement affaire

qu'à une suite d'affrontements stériles, où différentes coteries

intéressées par certaines conclusions n'ont fait qu'imaginer des

justifications à leurs intérêts ? Que les économistes n'ont

par définition produit que des discours idéologiques, et aucun résultat

scientifique ? Autrement dit, qu'en sciences sociales, le fait d'être

partisan est contradictoire avec le fait d'être objectif ? Pas

forcément.

On peut très bien défendre un point de vue partisan (au sens où

c'est un point de vue qui prend parti) tout en exprimant une vérité

scientifique. Ou alors, dans un domaine où tous les points

de vue sont partisans, cela voudrait dire que la vérité n'existe

pas, ce qui est une position philosophique bien difficile à

défendre.

Je prendrai un exemple d'autant plus parlant qu'il n'est pas

issu des sciences sociales, mais des sciences physiques : celui de

Galilée, qui avait découvert à la suite de Copernic que le foyer

du système solaire était le soleil, et non la Terre comme on le

croyait jusque là. De ces deux propositions, aucune n'était neutre

du point de vue de la société : l'une défendait le point de vue de

l'Église, force spirituelle mais aussi (et surtout ?) temporelle.

L'autre heurtait de front cette puissance... et Galilée en a su

quelque chose. Mais le fait que ces deux

points de vue étaient donc, qu'ils le veuillent ou non, partisans,

n'empêchait donc nullement l'un de ces points de vue d'être

scientifiquement juste (et l'autre d'être faux).

L'économie produit donc des discours

nécessairement partisans ; cela ne

l'empêche pas forcément de produire des énoncés scientifiques

(objectifs). Naturellement, cela ne signifie pas que tout

raisonnement est scientifiquement fondé du seul fait qu'il est

partisan ! Et inversement, on ne peut pas exclure a priori

l'hypothèse qu'aucun de ces discours partisans ne soit

scientifiquement fondés... Mais en conclusion :

- toute théorie économique est obligatoirement partisane.

- tout en étant partisane, une théorie peut être objective (scientifique).